New Release

WEEKEND ROUND UP – APRIL 15TH – 16TH

SATURDAY SALE

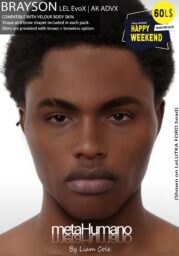

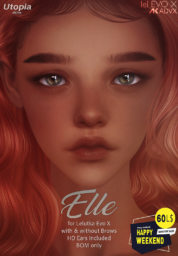

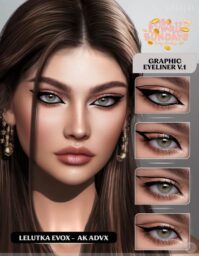

HAPPY WEEKEND

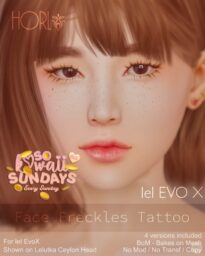

SO KAWAII SUNDAY

NEW- ND/MD LOU

available @ enLight + ND/MD main store

http://maps.secondlife.com/secondlife/Sugulite%20Island/191/164/25

ND/MD Weekend SALE – February

Teleport @ ND/MD Main shop

Recent Sales – Maybe Black Friday, Maybe not!

I’ll update this list periodically, or as I see things. This is more of a list for things not on the weekend sale lists.

Nov 25th – 27th — Some of these mods are Brilliant. Do not miss the sale if you have a compatible body. SLURL

Sale Details: All items are 50% off, except Body Skins & Body Add-ons are 30% off!

GHOST’INK – ALIYAH SKIN & Make-Up –

Spice UP YOUR Style !

A complete skin ( Face Skin + Body Skin or Face +Neck Fix )

A customable Make-Up , with all layers wearable separately .

Available now at We Love RP Event : 25% OFF

http://maps.secondlife.com/secondlife/Riverhunt/129/128/27

DEMOS MAINSTORE GHOST INK

http://maps.secondlife.com/secondlife/Nori/74/89/924

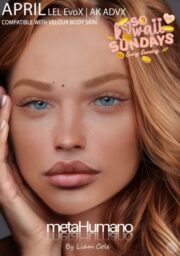

Nuve – Hannah Skin/Eyebrows/Eyeshadows/Lipstick – Lelutka Evo X/AK ADVX

Check out our new exclusives for the Anthem event.

Made with love for Lelutka Evo X, also compatible with AK ADVX

– Brows & Browless face

– Basic body skin v 2 (universal fit)

– Tintable eyeliners

– Skin tinter

– shape for Lelutka Evo X Avalon

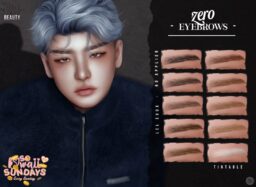

Eyebrows:

HD or BOM version, 6 colors (Tintable)

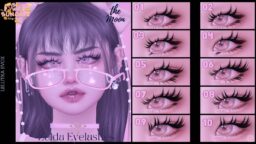

Eyeshadows:

BOM version in 14 presets and 2 gray colors (tintable)

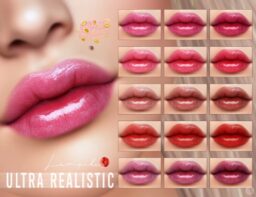

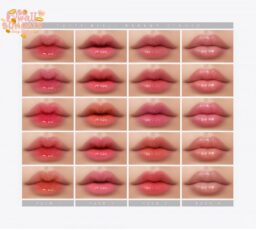

Lipstick:

HD or BOM version, 14 presets and 2 gray colors (tintable)

ANTHEM

MAINSTORE

FLICKR

FACEBOOK

INSTAGRAM

DISCORD SERVER

Weekend Sales Roundup – October 22nd – 23rd

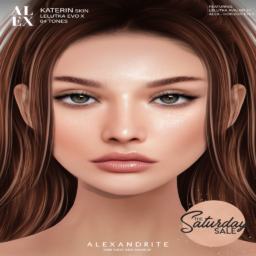

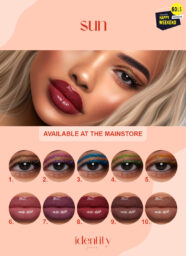

Saturday Sale

7 DEADLY SKINS Moments SKin – Genus – TELEPORT

ALEXANDRITE Satheo Skin – Evo X – TELEPORT

CAZIMI Kiss Me Ghoul Recolor Lipstick- Evo X – TELEPORT

DERNIER Elvira Lipstick – Lelutka – TELEPORT

GLAM AFFAIR Sevyn Skin – Evo X – TELEPORT

GOREGLAM Libra Lipgloss – TELEPORT

HERON SHOP Mistic Makeup – Lelutka – TELEPORT

HERON SHOP Jean Makeup – Lelutka – TELEPORT

KOONZ Anna Skin – TELEPORT

KOONZ Queen Liner – TELEPORT

SUGAROSE Selma – Evo X – TELEPORT

SUGAROSE Prudence – Evo X – TELEPORT

TEMIZI STORE Yulia Makeup – Lelutka – TELEPORT

TEMIZI STORE Marilia Makeup – Lelutka – TELEPORT

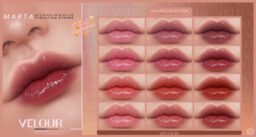

VELOUR Belinda Lips – BOM/Lelutka HD – TELEPORT

VELOUR Gillian Eyeshadow – BOM/Lelutka HD – TELEPORT

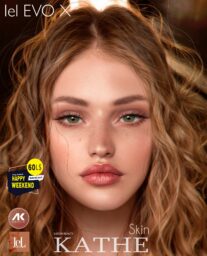

Happy Weekend

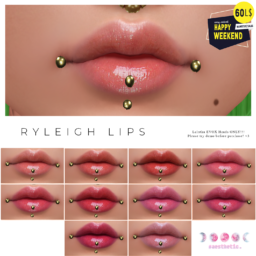

AESTHETIC Tiffany Lips – Evo X – TELEPORT

AESTHETIC Asha Lips – Evo X – TELEPORT

COSMETIZE Cherry Skin – Evo X – TELEPORT

EUDORA BEAUTY Sabine Fantasy Skin – Evo X – TELEPORT

GUAPA Selma Skin & Fantasy Skin – AK ADVX/Evo X – TELEPORT

LUCCI Halloween Lipstick – – TELEPORT

LUEUR Essential Liners – Evo X – TELEPORT

LUEUR Blaire Skin – Evo X – TELEPORT

MOCCINO Lulu Skin – Evo X – TELEPORT

NUVE Dramatic Eyeliners – AK ADVX/Evo X – TELEPORT

PURPLE Astral Skin – Evo X – TELEPORT

VELOUR Gael Fantasy Skin – Evo X – TELEPORT

VELOUR Gael Skin – Evo X – TELEPORT

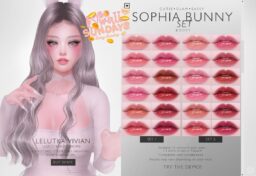

So Kawaii Sunday

BELANTTI Butterfly Eyeshadow Collection – Evo X – TELEPORT

BELANTTI Glossy Set – Evo X – TELEPORT

BNNB Morgan – Evo X – TELEPORT

Boopy Mandy Set – Evo X – TELEPORT

FONTAINE Lolita – Evo X – TELEPORT

FONTAINE Sweetness – Evo X – TELEPORT

K BEAUTY Amon Lips – Evo X – TELEPORT

K BEAUTY Angela Eyeshadows – Evo X – TELEPORT

MILANI Makeup Set – Evo X – TELEPORT

MILANI Makeup Set – Evo X – TELEPORT

POPPET Isa Skin – Evo X – TELEPORT

POPPET Cutesy Shadows – AK ADVX/Evo X – TELEPORT

SUGAROSE Alanis Set – Evo X – TELEPORT

SUGAROSE Anabel Set – Evo X – TELEPORT

TEAR Eva Gloss – Evo X – TELEPORT

UNHOLY Maeve Skin – Evo X – TELEPORT

Weekend Sales Roundup – October 1st – 2nd

SATURDAY SALE

7 DEADLY Sixteen Skin – TELEPORT

CAZIMI Lilith Evo X Lipstick – TELEPORT

GOREGLAM Tenebrae Eyeliners – Lelutka Evo & Evo X – TELEPORT

GOREGLAM Rosethorn Gloss – Lelutka Evo & Evo X – TELEPORT

HERON Dricka Makeup – Lelutka – TELEPORT

HERON Lilith Makeup – Lelutka – TELEPORT

SUGAROSE Rosalie Skin – Lelutka Evo X – TELEPORT

SUGAROSE Rosalie – Lipstick and Eyeshadow – TELEPORT

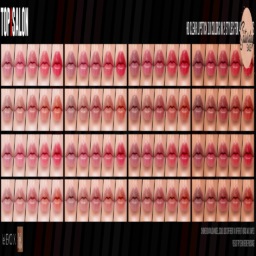

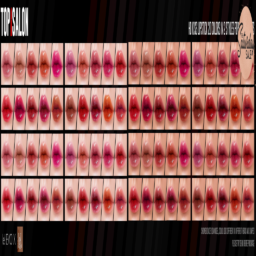

TOP1SALON Lipstick – Genus/Lelutka Evo/Evo X – TELEPORT

VEECHI Spectral Eyes Natural – TELEPORT

VELOUR Brayelin Lips – BOM/Evo X – TELEPORT

VELOUR Luana Eyeshadow – BOM/Evo X – TELEPORT

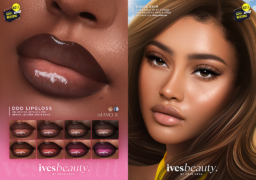

Happy Weekend

BEAUMORE Giovanna Lipstick – Lel Evo X – TELEPORT

GUAPA Desire Skin – AK ADVX / Lel Evo X – TELEPORT

GUAPA Desire Eyeshadow – AK ADVX / Lel Evo X – TELEPORT

IVES BEAUTY Cajuina Gloss – Genus/Lel Evo/Evo X – TELEPORT

JACK SPOON Lanchester contour V2 – Lel Evo X – TELEPORT

LUEUR Cassie Skin – Lel Evo X – TELEPORT

METAHUMANO Maya Skin – Lel Evo X – TELEPORT

METAHUMANO Dylan Skin – Lel Evo X – TELEPORT

MOCCINO Boo Skin – Lel Evo X – TELEPORT

NONNATIVE Jinsui Skin – Lel Evo X – TELEPORT

SUICIDAL UNBORN Funeral Eyeshadow – Lel Evo X – TELEPORT

VELOUR Chris Skin – Lel Evo X – TELEPORT

VELOUR Chris Fantasy Skin – Lel Evo X – TELEPORT

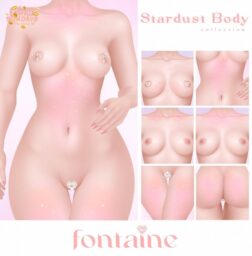

So Kawaii Sunday

FONTAINE Wildheart – Lel Evo X – TELEPORT

FONTAINE Kitty – Lel Evo X – TELEPORT

GOTHIC MERMAID Incubus – Lel Evo X – TELEPORT

GOTHIC MERMAID Libby Palette – Lel Evo X – TELEPORT

KOONZ BEAUTY Sara Lipstick – Lel Evo X – TELEPORT

METAHUMANO Alex Skin – Lel Evo X – TELEPORT

MILANI Quinzel Collection – Lel Evo X – TELEPORT

MILANI Molly Collection – Lel Evo X – TELEPORT

POPPET SKINS Yuna Skin – AK ADVX/Lel Evo X – TELEPORT

POPPET SKINS Chan Skin – AK ADVX/Lel Evo X – TELEPORT

REED SKINS Fairy Skin – Lel Evo X – TELEPORT

REED SKINS Cleo Skin – Lel Evo X – TELEPORT

SUGAROSE Lauriel – Lel Evo/Evo X – TELEPORT

SUGAROSE Lucy – Lel Evo/Evo X – TELEPORT

TUTTI BELLI Scream Queens Eyeshadow – Lel Evo X – TELEPORT

TUTTI BELLI Speed Lipsticks – Lel Evo X – TELEPORT

UNHOLY Rita’s Eyeshadow – AK ADV/Lel Evo X – TELEPORT